- 확률적 모델링

- 통계학 이론을 데이터 분석에 응용하였음

- 나이브 베이즈 알고리즘

- 로지스틱 회귀

- 커널 방법

- 입력 데이터를 새로운 고차원 표현으로 매핑하여 분류하는 방법

- 서포트 벡터 머신(SVM)

- 초창기 신경망

- 1950년대 시작했으나 대규모 신경망을 훈련시킬 수 없었음

- 신경망 구조

- Input layer: 입력 데이터를 받아들이며, 하나의 node가 하나의 속성을 표현

- Output layer: 분류된 클래스 정보를 표현하며, 회귀모델의 계수 값과 같이 학습을 통해 알아내고자 하는 목적 속성을 도출

- Hidden layer: Input layer에서 받은 정보를 처리하기 위한 nodes로 이루어져 있으며, 2개 이상의 layer로 구성될 수 있음

- Learning: 입력 데이터가 어떻게 처리되고 어떤 모델을 도출할 것인지를 결정하는 과정

- 결정트리, 랜덤 포레스트, 그래디언트 부스팅 머신

- 랜덤 포레스트: 서로 다른 결정 트리를 많이 만들고, 그 출력을 앙상블하는 방법

- 그래디언트 부스팅 머신: 결정 트리를 앙상블하는 것을 기반으로 이전 트리의 오차를 보완하는 방식으로 순차적으로 트리 생성

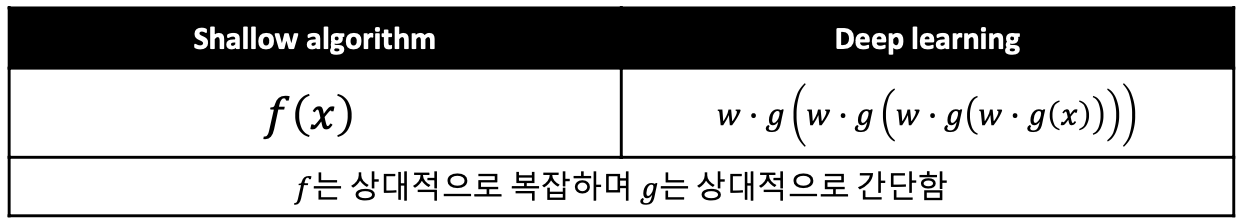

- Shallow 알고리즘

- 여러 층의 hidden layer를 갖는 deep learning과 상반되는 개념으로 다층 구조를 갖고 1~2개의 hidden layer를 갖는 기존의 학습 알고리즘들을 일컬음

- Deep Learning의 발전

- DL의 기본 개념은 Artificial neural network(ANN)와 동일

- Hidden layer를 많이 갖는 DL의 컨셉은 1980년대에 Multilayer perception에서 이미 개발됨

- 1980년 당시에는 DL이 성공하지 못한 이유

- Back propacation 방법은 hidden layer가 2개만 되고 네트워크를 잘 학습시키지 못했음

- DL의 non-convex한 목적식 때문에 최적해를 구하기 어려움

- 국소 최적해들이 많아서 그것에 빠지기 쉬움

- 2006년 토론토 대학의 Geoffrey Hinton이 Deep network를 깊은 층까지 학습시킬 수 있는 Deep belief network(DBN) 발표

- upsupervised learning을 통해 데이터 집합에서 비슷한 것들은 묶고 특이한 것들을 제거하는 pre-training 과정을 거쳐 네트워크를 학습 -> 국소 최적해에 훨씬 적게 빠지고 Deep network도 잘 학습시킴

- DL은 기존의 기계학습 알고리즘들 보다 월등히 뛰어난 모델링 능력을 가지고 있음이 실험을 통해 밝혀짐

- 심층신경망

- 2011년 IDSIA의 댄 크리슨이 GPU로 훈련된 심층신경망으로 학술 이미지 분류 대회에서 우승

- 2012년 대규모 이미지 분류 대회인 ImageNet에서 힌튼 팀이 심층 합성곱 신경망으로 우승

'데이터사이언스' 카테고리의 다른 글

| 딥러닝의 수학적 구성 요소 (0) | 2019.10.23 |

|---|---|

| 딥러닝의 필요성 (0) | 2019.10.22 |

| 인공지능과 머신러닝 그리고 딥러닝 소개 (0) | 2019.10.22 |

| 연관규칙의 support와 confidence (0) | 2019.06.21 |

| K-means와 DBSCAN 비교 (0) | 2019.06.21 |